NVIDIAは8日、統合された使いやすいワークスペースである「NVIDIA AI Workbench」を発表した。

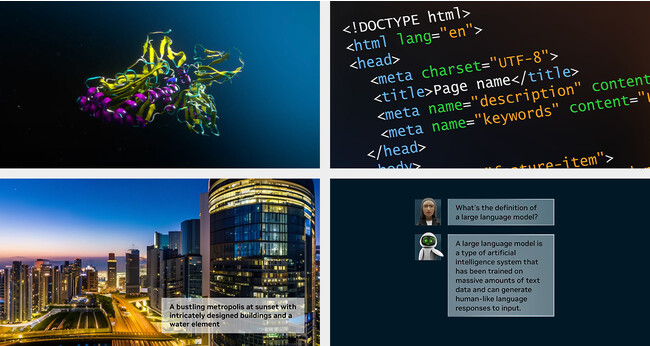

これにより、開発者は PC またはワークステーション上で事前トレーニング済みの生成 AI 向けの大規模言語モデル (LLM) を迅速に作成、テスト、カスタマイズ可能となり、それらを事実上あらゆるデータセンター、パブリック クラウド、または NVIDIA DGX Cloudに拡張できる。

「AI Workbench」は、エンタープライズ AI プロジェクトを開始する際の複雑さを解消する。ローカル システム上で実行される簡素化されたインターフェイスを通じてアクセスできるため、開発者は Hugging Face、GitHub、NVIDIA NGCなどの一般的なリポジトリからのモデルをカスタムのデータを使用してカスタマイズでき、複数のプラットフォーム間で簡単に共有できる。

現在、何十万もの事前トレーニング済みモデルが利用可能だが、利用可能な多くのオープンソース ツールを使用してそれらをカスタマイズするのは困難で時間がかかる場合がある。大規模な AI プロジェクトでは、複数のオンライン リポジトリを検索して適切なフレームワーク、ツール、コンテナを探し、適切なスキルセットを採用して特定のユースケースに合わせてモデルをカスタマイズする必要がある。そのプロジェクトを、あるコンピューティング インフラストラクチャから別のコンピューティング インフラストラクチャに移動するには、プロセスを再度やり直さなければならない。

NVIDIA AI Workbench を使用すると、開発者は数回クリックするだけで生成 AI をカスタマイズして実行することが可能。これにより、必要なすべてのエンタープライズ グレードのモデル、フレームワーク、SDK、ライブラリをオープンソース リポジトリと NVIDIA AI プラットフォームから統合された開発者ワークスペースにまとめることができる。

Dell Technologies、Hewlett Packard Enterprise、HP Inc.、Lambda、Lenovoおよび Supermicroなどの主要な AI インフラストラクチャ プロバイダーは、最新世代のマルチ GPU 対応デスクトップ ワークステーション、ハイエンド モバイル ワークステーション、仮想ワークステーションを強化する機能として AI Workbench を採用する。WindowsもしくはLinuxベースのNVIDIA RTX PC もしくはワークステーションを使用する開発者は、ローカルのRTXシステム上でエンタープライズ グレードの生成 AI プロジェクトを開始できるようになり、拡張の必要が生じた場合にはデータセンターやクラウド コンピューティングのリソースに簡単にアクセスが可能になる。

生成AIの導入をさらに加速するために、NVIDIA はエンタープライズ ソフトウェア プラットフォームの最新バージョンである NVIDIA AI Enterprise 4.0を発表した。これにより、企業は生成 AI の導入に必要なツールにアクセスできるようになり、信頼性の高い運用展開に必要なセキュリティと API の安定性も提供される。