Robust Intelligence、生成AIモデルのリスクを検証・分析する評価サービスを提供開始

AIのリスクを適切に管理したモデルの運用“AI Integrity”を実現するシリコンバレー発のAIスタートアップ・Robust Intelligence, Inc.(米国カリフォルニア州:ロバストインテリジェンス)は30日、生成AIモデルのリスクを検証・分析する「生成AIリスク評価サービス」の提供を開始すると発表した。

ロバストインテリジェンスは、AIの開発段階から運用段階まで一貫して、テストベースでリスク検証を行うプラットフォーム「Robust Intelligence Platform」を、国内外の大手企業に提供してきた。

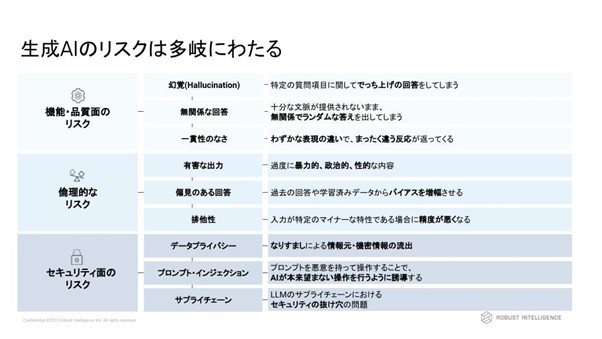

そんな中、昨今ではChatGPTを始めとする生成AIの利用が急速に広がる中で、不正確な出力や倫理的に問題のある出力、プロンプト・インジェクションなどの、これまでのAIモデルと異なる形のAIリスクが問題視されるようになった。これを受けて、各国政府の政策も転換しており、G7でも生成AIのリスク対策のための国際的ルール作りが急がれている。同社としても、自民党・AIプロジェクトチームへの参加などを通じて、急ピッチで進むAI政策の立案に貢献しているという。

こうした背景を受け、生成AIを企業が安心して活用するためのサポートを行うため、ロバストインテリジェンスは「生成AIリスク評価サービス」の提供を開始する。

このサービスは、従来のソリューションの基本的な考え方であるTest-Drivenアプローチを生成AIにも適用し、上記のような多岐にわたるAIリスクの検証・解決を行う。ロバストインテリジェンスのプラットフォームは日本のビジネス環境に準拠するため、日本語LLMにも適用可能であり、日本企業の準拠すべき各種規制にも対応している。また、各国政策や国内外のユースケースに関する知見を活かし、AIリスク管理において重要となる社内のAIガイドライン・プロセス整備等もサポートする。

【本サービスの特長】

・生成AIのリスクを包括的に検証する先進的なサービスにより、生成AIの実装を目指す企業にとってネックとなる「リスク対策」を一手に引き受け

・自動化したテストケースにより、不正な出力や有害な出力を防止

・セキュリティ上の脆弱性を検知・修復

・AIモデルが国内外の規制・ガイドラインに準拠していることを第三者の目線から確認